Transformer模型简介

《Attention Is All You Need》是一篇Google提出的将Attention思想发挥到极致的论文。这篇论文中提出一个全新的模型,叫 Transformer,抛弃了以往深度学习任务里面使用到的CNN和RNN,这个模型广泛应用于NLP领域,例如机器翻译,问答系统,文本摘要和语音识别等等方向。

Transformer发展介绍

自Attention机制提出后,加入Attention的Seq2Seq模型在各个任务上都有了提升,所以现在的Seq2Seq模型指的都是结合RNN和Attention的模型。后来,Google又提出了解决Seq2Seq问题的Transformer模型,用全Attention的结构代替了LSTM,在翻译任务上取得了更好的成绩。

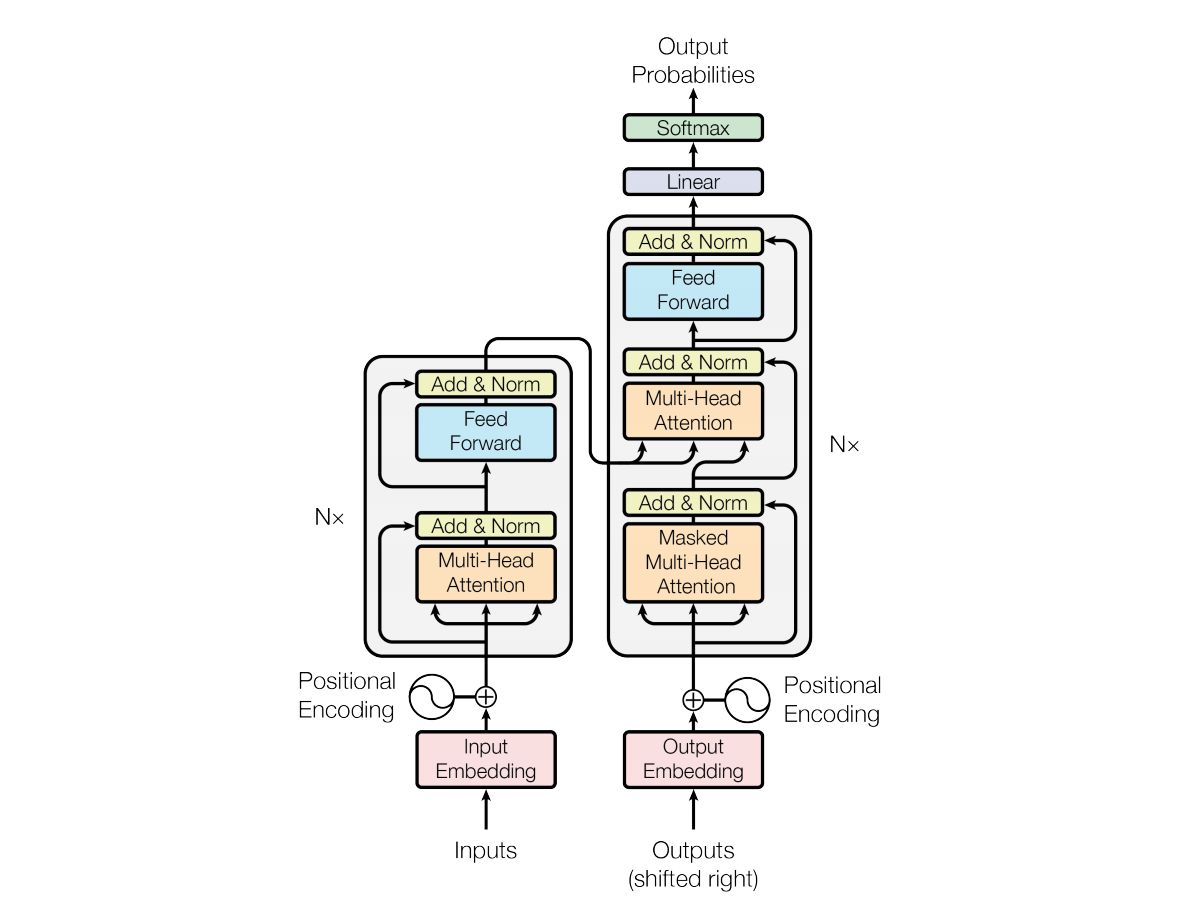

Transformer模型结构