多目标模型的意义

现实世界中,我们的业务目标往往不是单一的。比如购物APP中,我们不仅仅希望你浏览商品,也希望你购买商品,甚至分享商品,评论商品。再比如短视频推荐,我们不单希望你看视频,也希望你点赞、评论、分享视频,还希望你能关注发布的作者。因此多目标模型的出现,就可以让我们的场景同时服务到这些目标。于此同时,对于一些正样本稀疏的目标,多目标模型甚至可以让他们的目标实现远超预期。

MMoE简介

多任务学习的目的在于用一个模型来同时学习多个目标和任务,但常用的任务模型的预测质量通常对任务之间的关系很敏感,因此,Google 提出多门混合专家算法(Multi-gate Mixture-of-Experts,以下简称 MMoE)旨在学习如何从数据中权衡任务目标(task-specific objectives)和任务之间(inter-task relationships)的关系。所有任务之间共享混合专家结构(MoE)的子模型来适应多任务学习,同时还拥有可训练的门控网路(Gating Network)以优化每一个任务。MMoE 算法在任务相关性较低时能够具有更好的性能,同时也可以提高模型的可训练性。

MMOE结构如下:Expert是一个神经网络,Expert个数根据训练和预估性能做权衡,和任务数保持一致也可以。Gate是一个Softmax函数,个数与任务数一致,每个Gate的输出个数与Expert个数一致。

MMoE网络结构衍化图

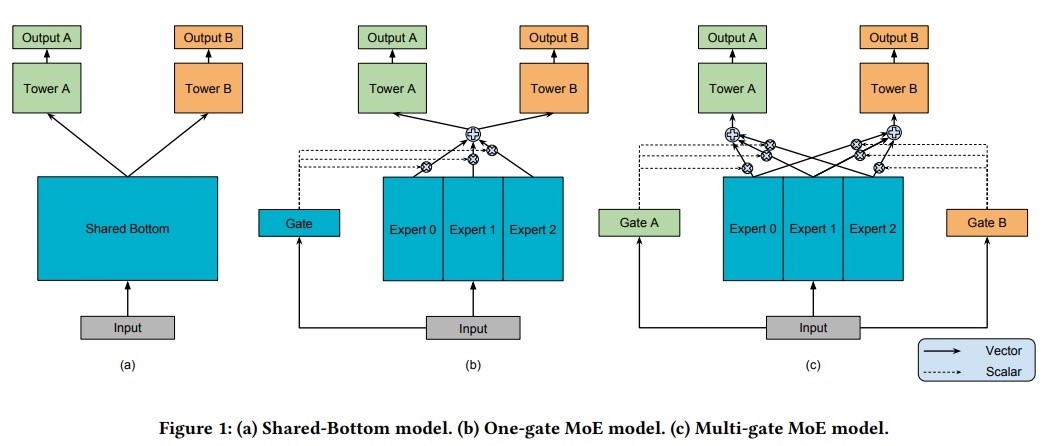

MMoE的网络结构衍化图,衍化的过程是为了更好地解决多目标问题。图( a ) 到 图( c ) 反映了在解决多目标问题时模型结构的迭代过程:

结论:图( c )最好,图( b )次之,图( a )最差

图( a )是最常规的共享网络的方案,结构是input首先经过底层共享的DNN网络(Shared Bottom)生成vector,再根据不同目标将vector经过各自的tower生成对应的output。

图( b )是将底层的一个DNN网络分解成3个专家网络(expert),通过一个共享门控(gate)来设置每个专家网络输出的权重,得到门控后的vector经过各自tower生成对应的output。

图( c )跟图( b )的思路类似,同样是通过门控为专家网络设置权重,再通过各自tower生成对应的output。不同的点在于,使用的门控不是共享门控,而是每个目标有独立的门控(gate),如果有两个目标则有两个门控。

通过上文的图片,MMoE的网络结构其实是比较好理解的,下面说一下衍化过程:

首先,图( a )的Shared-Bottom方式不能很好地处理不同目标样本空间不同的差异化,因此效果来看容易导致某个目标受另外一个目标影响较大。

其次,图( b )引入了gate和expert的思想,就是希望每个expert能学习到不同的信息,更好地服务多目标不同目标的样本空间。但是gate的权重对于两个目标是共享的,同样会导致差异化未被很好服务。

图( c )模型每个目标使用独立的gate权重,使每个expert对每个目标贡献不同,更好的处理了不同目标差异化的问题。

为什么要使用MMoE实现多目标?

1、MMoE通过特殊的模型结构达到了一个模型实现多个目标的能力

2、MMoE通过模型结构的优化使各项目标都很好的实现

3、MMoE可以通过网络共享帮助正样本稀疏的目标更好地达成